Multilayer Perceptron Networkの構築

MLPClassSaturnをもう少し詳しく解析してみる。

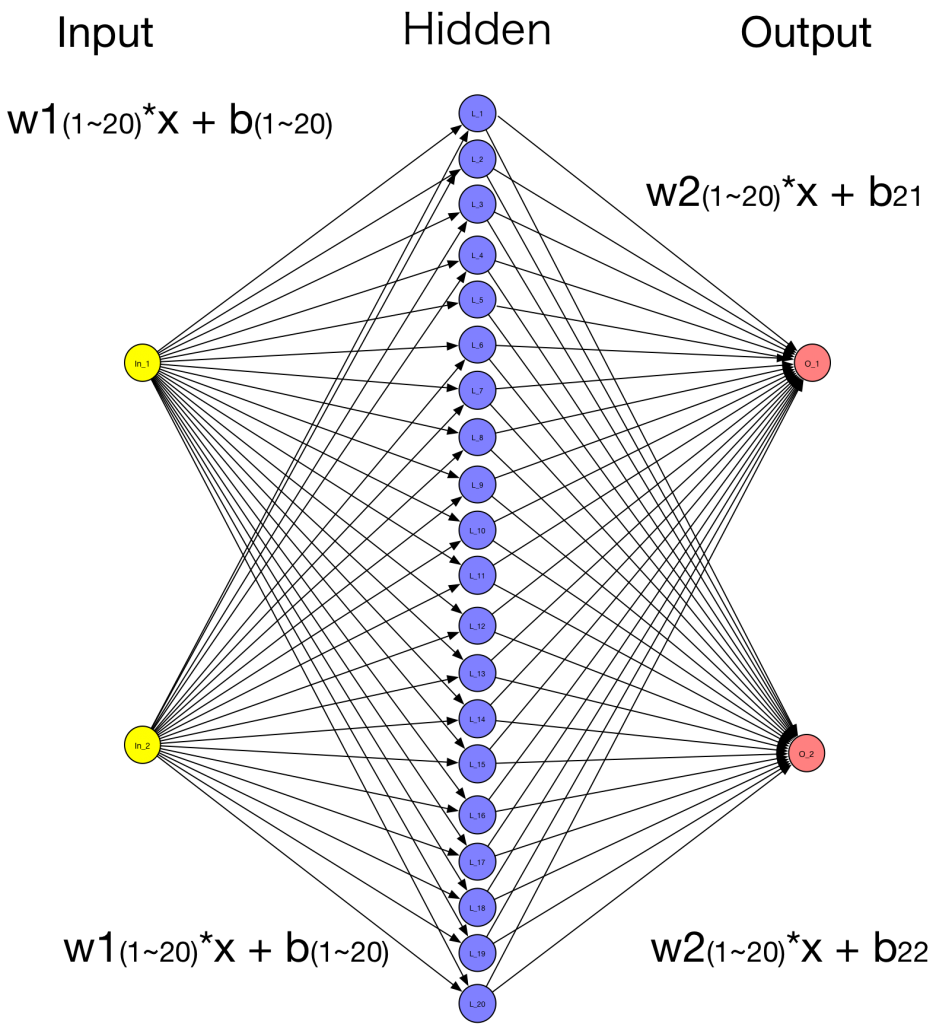

まず、Neural Networkの構造を描いてみる。2個のInputニューロンと2個のOutputニューロン、間に20個の隠れ層Neuronという構造である。

2個のInputニューロンから20個の隠れ層ニューロンへの重みw1, w2が20個x2=40個、隠れ層ニューロンのバイアス値b1-20がそれぞれニューロンごとで合計20個、ここまでで合計60個のパラメータ。次に隠れ層20個から2個のOutputニューロンへの重みw3が20個x2=40個と、Output層のバイアス値b2がそれぞれのOutputニューロン(b21, b22)にあり、合計2個で、隠れ層からOutput層には合計42個のパラメータ。全部合わせて総計102個の重み係数+バイアスパラメータとなる。

MultiLayerNetworkクラスのインスタンスであるmodelに、params()関数を与えると102個のパラメータが単純な横一列の配列で戻される。paramTable()関数を使えば、グループごと[w1:20個、w2:20個、b1-20:20個、w3:20個、b21, b22]にまとめられて戻される。

以下のようにコードを修正するとコンソールにパラメータ中間値が出力され、パラメータ変化を分析できる。

|

1 2 3 4 5 6 7 8 9 10 11 12 13 |

MultiLayerNetwork model = new MultiLayerNetwork(conf); model.init(); System.out.println(model.paramTable()); //パラメータ初期値(テーブル) System.out.println(model.params()); //パラメータ初期値 //model.setListeners(new ScoreIterationListener(1)); //Print score every 10 parameter updates for ( int n = 0; n < nEpochs; n++) { model.fit( trainIter ); System.out.println(model.params()); //エポックごとのパラメータ中間値 30段階 } System.out.println(model.summary()); System.out.println(model.paramTable()); //パラメータ最終値(テーブル) |

上記のコンソール出力は以下の通り:

|

1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 71 72 73 74 75 76 77 78 79 80 81 82 83 84 85 86 87 88 89 90 91 92 93 94 95 96 97 98 99 100 101 102 103 104 105 106 107 108 109 110 111 112 113 |

o.n.l.f.Nd4jBackend - Loaded [CpuBackend] backend o.n.n.NativeOpsHolder - Number of threads used for NativeOps: 2 o.n.n.Nd4jBlas - Number of threads used for BLAS: 2 o.n.l.a.o.e.DefaultOpExecutioner - Backend used: [CPU]; OS: [Mac OS X] o.n.l.a.o.e.DefaultOpExecutioner - Cores: [4]; Memory: [3.6GB]; o.n.l.a.o.e.DefaultOpExecutioner - Blas vendor: [MKL] o.d.n.m.MultiLayerNetwork - Starting MultiLayerNetwork with WorkspaceModes set to [training: ENABLED; inference: ENABLED], cacheMode set to [NONE] {0_W=[[ 0.6075, -0.3462, -0.3778, 0.2016, -0.3619, 0.0079, -0.1621, -0.0570, -0.1800, 0.2769, 0.3980, -0.1610, -0.4054, 0.3921, -0.4874, 0.0676, 0.5184, -0.3940, 0.1001, -0.0699], [ -0.2595, 0.1405, 0.2820, 0.3897, -0.9650, 0.0377, 0.0548, -0.3151, 0.2252, 0.0146, 0.6966, -0.3013, -0.2327, 0.2102, 0.0408, -0.1887, -0.0686, 0.1658, 0.1481, 0.4032]], 0_b=[[ 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0]], 1_W=[[ 0.2367, -0.3284], [ -0.5487, 0.2360], [ 0.6404, 0.0237], [ -0.1906, -0.4099], [ -0.0716, 0.2596], [ -0.2307, -0.2039], [ -0.3095, 0.0487], [ 0.3670, -0.4921], [ -0.2990, -0.0390], [ -0.0005, 0.3827], [ -0.1261, 0.6093], [ 0.3013, -0.2682], [ 0.2553, -0.0227], [ -0.0464, 0.1790], [ 0.1783, -0.3751], [ 0.4470, -0.7521], [ -0.0244, -0.1032], [ -0.3861, -0.2370], [ 0.1981, 0.0719], [ 0.0737, 0.0921]], 1_b=[[ 0, 0]]} [[ 0.6075, -0.2595, -0.3462, 0.1405, -0.3778, 0.2820, 0.2016, 0.3897, -0.3619, -0.9650, 0.0079, 0.0377, -0.1621, 0.0548, -0.0570, -0.3151, -0.1800, 0.2252, 0.2769, 0.0146, 0.3980, 0.6966, -0.1610, -0.3013, -0.4054, -0.2327, 0.3921, 0.2102, -0.4874, 0.0408, 0.0676, -0.1887, 0.5184, -0.0686, -0.3940, 0.1658, 0.1001, 0.1481, -0.0699, 0.4032, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0, 0.2367, -0.5487, 0.6404, -0.1906, -0.0716, -0.2307, -0.3095, 0.3670, -0.2990, -0.0005, -0.1261, 0.3013, 0.2553, -0.0464, 0.1783, 0.4470, -0.0244, -0.3861, 0.1981, 0.0737, -0.3284, 0.2360, 0.0237, -0.4099, 0.2596, -0.2039, 0.0487, -0.4921, -0.0390, 0.3827, 0.6093, -0.2682, -0.0227, 0.1790, -0.3751, -0.7521, -0.1032, -0.2370, 0.0719, 0.0921, 0, 0]] [[ 0.5585, -0.1634, -0.4435, 0.1016, -0.3025, 0.3131, 0.1956, 0.4011, -0.3673, -1.0402, 0.0070, 0.0369, -0.2070, 0.0362, -0.0639, -0.1426, -0.2124, 0.2114, 0.3158, -0.0423, 0.4215, 0.6576, -0.1263, -0.2008, -0.3742, -0.1986, 0.4119, 0.1860, -0.4167, 0.0856, 0.0159, 0.0730, 0.5127, -0.0604, -0.4135, 0.1573, 0.0946, 0.1559, -0.0713, 0.4027, 0.0003, -0.0125, 0.0084, 0.0065, 0.0016, -0.0007, -0.0050, -0.0120, -0.0046, -0.0045, -0.0198, -0.0076, -0.0020, -0.0046, 0.0033, -0.0134, -0.0002, -0.0032, 0.0035, -0.0005, 0.1372, -0.5856, 0.6097, -0.1762, -0.2716, -0.2293, -0.3273, 0.3071, -0.3101, -0.0282, -0.1023, 0.2388, 0.1785, -0.0590, 0.1192, 0.4130, -0.0858, -0.4265, 0.2029, 0.0790, -0.2289, 0.2730, 0.0543, -0.4244, 0.4597, -0.2053, 0.0665, -0.4322, -0.0278, 0.4103, 0.5855, -0.2057, 0.0541, 0.1916, -0.3160, -0.7180, -0.0418, -0.1965, 0.0670, 0.0867, 0.0171, -0.0171]] [[ 0.5480, -0.1280, -0.4503, 0.1206, -0.2847, 0.3191, 0.2012, 0.4087, -0.3388, -1.0269, 0.0054, 0.0364, -0.2097, 0.0470, -0.1000, -0.1196, -0.2189, 0.2096, 0.3176, -0.0660, 0.4139, 0.6291, -0.1303, -0.1893, -0.3676, -0.1931, 0.4127, 0.1727, -0.4066, 0.0820, 0.0157, 0.1879, 0.5085, -0.0564, -0.4135, 0.1619, 0.0965, 0.1609, -0.0718, 0.4022, 0.0143, -0.0528, 0.0337, 0.0196, -0.0293, -0.0019, -0.0234, 0.0128, -0.0164, -0.0234, -0.0531, 0.0076, 0.0026, -0.0162, 0.0240, 0.0195, -0.0022, -0.0141, 0.0105, -0.0008, 0.1141, -0.5892, 0.6010, -0.1584, -0.2723, -0.2281, -0.3287, 0.2942, -0.3127, -0.0291, -0.0709, 0.2316, 0.1747, -0.0495, 0.1089, 0.3985, -0.0949, -0.4336, 0.2101, 0.0832, -0.2058, 0.2765, 0.0631, -0.4421, 0.4603, -0.2064, 0.0679, -0.4193, -0.0252, 0.4113, 0.5541, -0.1985, 0.0579, 0.1821, -0.3057, -0.7035, -0.0327, -0.1895, 0.0599, 0.0825, 0.1066, -0.1066]] [[ 0.5485, -0.1280, -0.4377, 0.1865, -0.2852, 0.2886, 0.2074, 0.3995, -0.3093, -0.9788, 0.0041, 0.0372, -0.2038, 0.0773, -0.1231, -0.1596, -0.2166, 0.2276, 0.3121, -0.0589, 0.4041, 0.6440, -0.1382, -0.2143, -0.3677, -0.1987, 0.4100, 0.1770, -0.4106, 0.0513, 0.0463, 0.1759, 0.5061, -0.0530, -0.4095, 0.1794, 0.0993, 0.1564, -0.0720, 0.4022, 0.0304, -0.0925, 0.0589, 0.0326, -0.0677, -0.0029, -0.0420, 0.0523, -0.0277, -0.0431, -0.0808, 0.0312, 0.0090, -0.0272, 0.0471, 0.0632, -0.0049, -0.0257, 0.0174, -0.0011, 0.1187, -0.5931, 0.5834, -0.1656, -0.2026, -0.2294, -0.3298, 0.3004, -0.3242, -0.0235, -0.0816, 0.2444, 0.1927, -0.0483, 0.1083, 0.3859, -0.0891, -0.4406, 0.2076, 0.0643, -0.2104, 0.2804, 0.0807, -0.4349, 0.3906, -0.2052, 0.0690, -0.4255, -0.0137, 0.4056, 0.5647, -0.2113, 0.0400, 0.1809, -0.3050, -0.6910, -0.0384, -0.1825, 0.0623, 0.1014, 0.2065, -0.2065]] [[ 0.5424, -0.1270, -0.4375, 0.2047, -0.2849, 0.2771, 0.2042, 0.3982, -0.2935, -0.9620, 0.0035, 0.0376, -0.2035, 0.0863, -0.1281, -0.1749, -0.2159, 0.2346, 0.3184, -0.0579, 0.4135, 0.6439, -0.1395, -0.2239, -0.3672, -0.2003, 0.4134, 0.1776, -0.4109, 0.0409, 0.0534, 0.1720, 0.5063, -0.0522, -0.4095, 0.1836, 0.0972, 0.1560, -0.0723, 0.4021, 0.0443, -0.1281, 0.0824, 0.0454, -0.0945, -0.0038, -0.0581, 0.0879, -0.0389, -0.0583, -0.1076, 0.0518, 0.0153, -0.0368, 0.0683, 0.1159, -0.0070, -0.0367, 0.0243, -0.0021, 0.1102, -0.5975, 0.5782, -0.1682, -0.1786, -0.2299, -0.3316, 0.3037, -0.3294, -0.0285, -0.0906, 0.2496, 0.1980, -0.0556, 0.1084, 0.3838, -0.0970, -0.4445, 0.2065, 0.0570, -0.2019, 0.2849, 0.0859, -0.4323, 0.3666, -0.2047, 0.0708, -0.4288, -0.0086, 0.4107, 0.5737, -0.2166, 0.0346, 0.1883, -0.3052, -0.6888, -0.0306, -0.1786, 0.0634, 0.1087, 0.2942, -0.2942]] [[ 0.5352, -0.1210, -0.4555, 0.1933, -0.2778, 0.2773, 0.1991, 0.4009, -0.2911, -0.9725, 0.0030, 0.0376, -0.2114, 0.0820, -0.1177, -0.1598, -0.2195, 0.2347, 0.3281, -0.0643, 0.4276, 0.6354, -0.1320, -0.2153, -0.3641, -0.1964, 0.4183, 0.1756, -0.4030, 0.0465, 0.0535, 0.1752, 0.5074, -0.0531, -0.4150, 0.1792, 0.0943, 0.1576, -0.0728, 0.4018, 0.0559, -0.1571, 0.1031, 0.0577, -0.1122, -0.0048, -0.0711, 0.1179, -0.0491, -0.0706, -0.1330, 0.0682, 0.0207, -0.0456, 0.0860, 0.1716, -0.0092, -0.0464, 0.0309, -0.0037, 0.0971, -0.6064, 0.5769, -0.1661, -0.2021, -0.2300, -0.3358, 0.3000, -0.3330, -0.0375, -0.0949, 0.2444, 0.1881, -0.0636, 0.1032, 0.3879, -0.1089, -0.4511, 0.2073, 0.0555, -0.1888, 0.2937, 0.0872, -0.4344, 0.3901, -0.2046, 0.0750, -0.4251, -0.0050, 0.4197, 0.5780, -0.2114, 0.0445, 0.1962, -0.3000, -0.6930, -0.0186, -0.1720, 0.0626, 0.1102, 0.3683, -0.3683]] [[ 0.5316, -0.1191, -0.4635, 0.1903, -0.2763, 0.2733, 0.1955, 0.4016, -0.2857, -0.9770, 0.0027, 0.0377, -0.2149, 0.0811, -0.1127, -0.1535, -0.2198, 0.2378, 0.3335, -0.0649, 0.4372, 0.6326, -0.1280, -0.2133, -0.3629, -0.1948, 0.4208, 0.1764, -0.3998, 0.0490, 0.0572, 0.1668, 0.5080, -0.0533, -0.4175, 0.1775, 0.0924, 0.1580, -0.0732, 0.4021, 0.0665, -0.1830, 0.1218, 0.0690, -0.1293, -0.0056, -0.0827, 0.1489, -0.0584, -0.0821, -0.1558, 0.0844, 0.0258, -0.0541, 0.1025, 0.2257, -0.0119, -0.0554, 0.0372, -0.0053, 0.0920, -0.6133, 0.5771, -0.1654, -0.2116, -0.2303, -0.3390, 0.3018, -0.3366, -0.0430, -0.1023, 0.2443, 0.1847, -0.0697, 0.1033, 0.3938, -0.1150, -0.4551, 0.2077, 0.0520, -0.1837, 0.3007, 0.0870, -0.4351, 0.3996, -0.2043, 0.0782, -0.4269, -0.0014, 0.4252, 0.5855, -0.2112, 0.0480, 0.2024, -0.3000, -0.6988, -0.0126, -0.1680, 0.0623, 0.1137, 0.4373, -0.4373]] [[ 0.5296, -0.1187, -0.4681, 0.1931, -0.2759, 0.2670, 0.1931, 0.4011, -0.2782, -0.9788, 0.0023, 0.0380, -0.2169, 0.0827, -0.1097, -0.1511, -0.2190, 0.2427, 0.3369, -0.0634, 0.4442, 0.6328, -0.1257, -0.2139, -0.3624, -0.1942, 0.4223, 0.1784, -0.3981, 0.0491, 0.0630, 0.1500, 0.5085, -0.0533, -0.4190, 0.1777, 0.0913, 0.1576, -0.0737, 0.4026, 0.0760, -0.2059, 0.1386, 0.0792, -0.1454, -0.0064, -0.0930, 0.1788, -0.0667, -0.0928, -0.1765, 0.0999, 0.0303, -0.0620, 0.1177, 0.2783, -0.0146, -0.0636, 0.0429, -0.0069, 0.0904, -0.6203, 0.5772, -0.1655, -0.2150, -0.2308, -0.3422, 0.3061, -0.3409, -0.0469, -0.1113, 0.2465, 0.1838, -0.0750, 0.1051, 0.4011, -0.1185, -0.4588, 0.2079, 0.0472, -0.1820, 0.3076, 0.0869, -0.4351, 0.4030, -0.2038, 0.0814, -0.4312, 0.0029, 0.4291, 0.5944, -0.2134, 0.0489, 0.2076, -0.3019, -0.7061, -0.0091, -0.1643, 0.0620, 0.1185, 0.5001, -0.5001]] [[ 0.5276, -0.1173, -0.4746, 0.1934, -0.2742, 0.2627, 0.1910, 0.4013, -0.2707, -0.9835, 0.0019, 0.0381, -0.2196, 0.0833, -0.1060, -0.1453, -0.2191, 0.2466, 0.3407, -0.0637, 0.4514, 0.6305, -0.1230, -0.2128, -0.3617, -0.1934, 0.4240, 0.1793, -0.3957, 0.0503, 0.0599, 0.1349, 0.5091, -0.0539, -0.4209, 0.1772, 0.0903, 0.1577, -0.0744, 0.4030, 0.0843, -0.2258, 0.1536, 0.0885, -0.1594, -0.0070, -0.1023, 0.2061, -0.0744, -0.1024, -0.1955, 0.1138, 0.0342, -0.0694, 0.1316, 0.3300, -0.0174, -0.0710, 0.0482, -0.0085, 0.0882, -0.6277, 0.5777, -0.1640, -0.2224, -0.2311, -0.3456, 0.3104, -0.3450, -0.0514, -0.1183, 0.2480, 0.1818, -0.0798, 0.1065, 0.4107, -0.1225, -0.4628, 0.2088, 0.0435, -0.1799, 0.3151, 0.0863, -0.4366, 0.4104, -0.2034, 0.0848, -0.4355, 0.0071, 0.4335, 0.6015, -0.2149, 0.0509, 0.2124, -0.3033, -0.7158, -0.0051, -0.1602, 0.0612, 0.1222, 0.5558, -0.5558]] [[ 0.5260, -0.1152, -0.4825, 0.1932, -0.2712, 0.2594, 0.1897, 0.4021, -0.2631, -0.9888, 0.0015, 0.0383, -0.2231, 0.0834, -0.1019, -0.1378, -0.2201, 0.2497, 0.3441, -0.0652, 0.4578, 0.6265, -0.1202, -0.2113, -0.3609, -0.1927, 0.4256, 0.1794, -0.3926, 0.0518, 0.0536, 0.1183, 0.5097, -0.0549, -0.4233, 0.1768, 0.0895, 0.1580, -0.0753, 0.4033, 0.0916, -0.2436, 0.1671, 0.0970, -0.1721, -0.0077, -0.1105, 0.2318, -0.0812, -0.1112, -0.2129, 0.1264, 0.0376, -0.0763, 0.1442, 0.3807, -0.0200, -0.0778, 0.0530, -0.0102, 0.0863, -0.6357, 0.5783, -0.1611, -0.2306, -0.2314, -0.3492, 0.3150, -0.3492, -0.0557, -0.1234, 0.2494, 0.1793, -0.0837, 0.1076, 0.4222, -0.1261, -0.4674, 0.2102, 0.0405, -0.1780, 0.3230, 0.0858, -0.4394, 0.4187, -0.2031, 0.0884, -0.4401, 0.0113, 0.4379, 0.6066, -0.2163, 0.0533, 0.2164, -0.3044, -0.7272, -0.0014, -0.1557, 0.0597, 0.1252, 0.6057, -0.6057]] [[ 0.5247, -0.1131, -0.4900, 0.1941, -0.2681, 0.2562, 0.1895, 0.4028, -0.2545, -0.9934, 0.0010, 0.0384, -0.2265, 0.0837, -0.0969, -0.1315, -0.2217, 0.2526, 0.3469, -0.0672, 0.4628, 0.6220, -0.1183, -0.2102, -0.3602, -0.1923, 0.4268, 0.1790, -0.3896, 0.0528, 0.0464, 0.0953, 0.5102, -0.0560, -0.4256, 0.1767, 0.0891, 0.1585, -0.0764, 0.4036, 0.0982, -0.2597, 0.1791, 0.1049, -0.1837, -0.0082, -0.1180, 0.2561, -0.0872, -0.1193, -0.2288, 0.1378, 0.0405, -0.0827, 0.1558, 0.4307, -0.0226, -0.0840, 0.0574, -0.0118, 0.0849, -0.6436, 0.5787, -0.1575, -0.2372, -0.2317, -0.3528, 0.3202, -0.3535, -0.0598, -0.1271, 0.2513, 0.1775, -0.0870, 0.1088, 0.4352, -0.1293, -0.4720, 0.2120, 0.0377, -0.1766, 0.3309, 0.0853, -0.4430, 0.4252, -0.2029, 0.0920, -0.4453, 0.0155, 0.4419, 0.6103, -0.2183, 0.0552, 0.2196, -0.3055, -0.7402, 0.0017, -0.1511, 0.0579, 0.1280, 0.6507, -0.6507]] [[ 0.5233, -0.1108, -0.4970, 0.1950, -0.2651, 0.2533, 0.1898, 0.4040, -0.2454, -0.9981, 0.0004, 0.0384, -0.2297, 0.0839, -0.0926, -0.1223, -0.2236, 0.2547, 0.3497, -0.0706, 0.4673, 0.6161, -0.1173, -0.2089, -0.3595, -0.1919, 0.4282, 0.1777, -0.3867, 0.0546, 0.0356, 0.0675, 0.5108, -0.0574, -0.4277, 0.1766, 0.0888, 0.1594, -0.0777, 0.4037, 0.1040, -0.2743, 0.1901, 0.1123, -0.1941, -0.0087, -0.1248, 0.2798, -0.0928, -0.1268, -0.2432, 0.1479, 0.0430, -0.0887, 0.1664, 0.4799, -0.0250, -0.0898, 0.0615, -0.0134, 0.0834, -0.6510, 0.5795, -0.1530, -0.2435, -0.2319, -0.3562, 0.3256, -0.3574, -0.0638, -0.1293, 0.2533, 0.1758, -0.0897, 0.1101, 0.4496, -0.1325, -0.4762, 0.2142, 0.0357, -0.1751, 0.3384, 0.0846, -0.4475, 0.4316, -0.2027, 0.0954, -0.4507, 0.0194, 0.4460, 0.6125, -0.2202, 0.0568, 0.2224, -0.3069, -0.7547, 0.0049, -0.1468, 0.0558, 0.1300, 0.6912, -0.6912]] [[ 0.5220, -0.1081, -0.5053, 0.1946, -0.2613, 0.2513, 0.1902, 0.4060, -0.2363, -1.0037, -0.0001, 0.0384, -0.2335, 0.0835, -0.0883, -0.1099, -0.2262, 0.2562, 0.3523, -0.0756, 0.4705, 0.6091, -0.1164, -0.2068, -0.3587, -0.1916, 0.4295, 0.1755, -0.3832, 0.0569, 0.0248, 0.0449, 0.5113, -0.0591, -0.4303, 0.1762, 0.0886, 0.1606, -0.0791, 0.4037, 0.1092, -0.2875, 0.2001, 0.1192, -0.2030, -0.0092, -0.1309, 0.3019, -0.0979, -0.1336, -0.2564, 0.1566, 0.0451, -0.0942, 0.1760, 0.5264, -0.0274, -0.0950, 0.0654, -0.0149, 0.0817, -0.6586, 0.5801, -0.1475, -0.2510, -0.2320, -0.3597, 0.3308, -0.3611, -0.0680, -0.1297, 0.2548, 0.1736, -0.0919, 0.1109, 0.4655, -0.1358, -0.4808, 0.2168, 0.0344, -0.1734, 0.3460, 0.0839, -0.4531, 0.4390, -0.2026, 0.0989, -0.4559, 0.0232, 0.4501, 0.6128, -0.2217, 0.0590, 0.2245, -0.3076, -0.7705, 0.0082, -0.1423, 0.0532, 0.1313, 0.7272, -0.7272]] [[ 0.5207, -0.1058, -0.5144, 0.1951, -0.2574, 0.2485, 0.1908, 0.4073, -0.2278, -1.0094, -0.0007, 0.0384, -0.2377, 0.0837, -0.0829, -0.0963, -0.2290, 0.2582, 0.3550, -0.0809, 0.4734, 0.6037, -0.1153, -0.2046, -0.3578, -0.1913, 0.4311, 0.1736, -0.3794, 0.0585, 0.0221, 0.0405, 0.5120, -0.0608, -0.4331, 0.1765, 0.0884, 0.1615, -0.0806, 0.4038, 0.1137, -0.2993, 0.2089, 0.1257, -0.2107, -0.0097, -0.1362, 0.3227, -0.1023, -0.1399, -0.2681, 0.1643, 0.0469, -0.0992, 0.1845, 0.5670, -0.0296, -0.0995, 0.0691, -0.0162, 0.0798, -0.6666, 0.5800, -0.1427, -0.2586, -0.2322, -0.3634, 0.3360, -0.3653, -0.0722, -0.1310, 0.2560, 0.1711, -0.0943, 0.1111, 0.4815, -0.1393, -0.4858, 0.2190, 0.0325, -0.1715, 0.3540, 0.0840, -0.4578, 0.4466, -0.2024, 0.1026, -0.4611, 0.0273, 0.4543, 0.6141, -0.2230, 0.0615, 0.2270, -0.3078, -0.7866, 0.0117, -0.1373, 0.0509, 0.1333, 0.7592, -0.7592]] [[ 0.5191, -0.1047, -0.5217, 0.1981, -0.2550, 0.2434, 0.1909, 0.4073, -0.2193, -1.0136, -0.0012, 0.0386, -0.2410, 0.0855, -0.0749, -0.0844, -0.2310, 0.2618, 0.3580, -0.0847, 0.4770, 0.6019, -0.1145, -0.2032, -0.3571, -0.1912, 0.4329, 0.1732, -0.3764, 0.0588, 0.0202, 0.0382, 0.5128, -0.0617, -0.4353, 0.1777, 0.0880, 0.1617, -0.0818, 0.4043, 0.1177, -0.3101, 0.2166, 0.1317, -0.2181, -0.0100, -0.1410, 0.3432, -0.1062, -0.1458, -0.2784, 0.1717, 0.0485, -0.1037, 0.1922, 0.6036, -0.0316, -0.1037, 0.0723, -0.0174, 0.0778, -0.6740, 0.5794, -0.1403, -0.2641, -0.2325, -0.3667, 0.3417, -0.3698, -0.0763, -0.1354, 0.2577, 0.1694, -0.0979, 0.1116, 0.4971, -0.1429, -0.4904, 0.2203, 0.0291, -0.1695, 0.3613, 0.0847, -0.4603, 0.4522, -0.2021, 0.1060, -0.4668, 0.0319, 0.4584, 0.6185, -0.2246, 0.0633, 0.2306, -0.3084, -0.8022, 0.0154, -0.1327, 0.0496, 0.1366, 0.7880, -0.7880]] [[ 0.5177, -0.1041, -0.5271, 0.2016, -0.2538, 0.2377, 0.1909, 0.4066, -0.2103, -1.0172, -0.0016, 0.0388, -0.2433, 0.0876, -0.0634, -0.0717, -0.2320, 0.2660, 0.3606, -0.0873, 0.4806, 0.6018, -0.1143, -0.2019, -0.3566, -0.1912, 0.4346, 0.1736, -0.3742, 0.0587, 0.0181, 0.0359, 0.5136, -0.0622, -0.4369, 0.1792, 0.0874, 0.1616, -0.0829, 0.4050, 0.1214, -0.3202, 0.2237, 0.1373, -0.2250, -0.0104, -0.1455, 0.3640, -0.1097, -0.1512, -0.2875, 0.1789, 0.0499, -0.1079, 0.1993, 0.6377, -0.0336, -0.1076, 0.0754, -0.0186, 0.0764, -0.6804, 0.5790, -0.1388, -0.2685, -0.2329, -0.3696, 0.3479, -0.3741, -0.0799, -0.1409, 0.2596, 0.1683, -0.1017, 0.1127, 0.5124, -0.1461, -0.4942, 0.2212, 0.0254, -0.1681, 0.3677, 0.0851, -0.4617, 0.4565, -0.2017, 0.1088, -0.4730, 0.0361, 0.4620, 0.6241, -0.2265, 0.0643, 0.2344, -0.3095, -0.8175, 0.0186, -0.1289, 0.0487, 0.1403, 0.8144, -0.8144]] [[ 0.5165, -0.1036, -0.5314, 0.2045, -0.2534, 0.2320, 0.1909, 0.4059, -0.2015, -1.0205, -0.0020, 0.0390, -0.2452, 0.0892, -0.0473, -0.0555, -0.2325, 0.2702, 0.3628, -0.0896, 0.4839, 0.6020, -0.1142, -0.2006, -0.3562, -0.1911, 0.4362, 0.1742, -0.3723, 0.0589, 0.0162, 0.0347, 0.5142, -0.0626, -0.4381, 0.1805, 0.0869, 0.1615, -0.0838, 0.4057, 0.1247, -0.3297, 0.2302, 0.1425, -0.2315, -0.0107, -0.1498, 0.3855, -0.1131, -0.1564, -0.2960, 0.1857, 0.0512, -0.1118, 0.2058, 0.6698, -0.0354, -0.1113, 0.0782, -0.0197, 0.0754, -0.6859, 0.5789, -0.1375, -0.2726, -0.2332, -0.3722, 0.3546, -0.3779, -0.0832, -0.1463, 0.2614, 0.1674, -0.1053, 0.1142, 0.5274, -0.1489, -0.4974, 0.2221, 0.0220, -0.1671, 0.3733, 0.0851, -0.4630, 0.4606, -0.2014, 0.1114, -0.4797, 0.0400, 0.4653, 0.6295, -0.2284, 0.0652, 0.2379, -0.3110, -0.8324, 0.0213, -0.1257, 0.0479, 0.1437, 0.8387, -0.8387]] [[ 0.5153, -0.1033, -0.5351, 0.2072, -0.2532, 0.2263, 0.1907, 0.4052, -0.1920, -1.0236, -0.0023, 0.0392, -0.2469, 0.0906, -0.0321, -0.0362, -0.2326, 0.2743, 0.3651, -0.0919, 0.4873, 0.6025, -0.1142, -0.1995, -0.3558, -0.1911, 0.4378, 0.1748, -0.3708, 0.0590, 0.0136, 0.0330, 0.5150, -0.0629, -0.4392, 0.1817, 0.0864, 0.1613, -0.0847, 0.4064, 0.1277, -0.3386, 0.2363, 0.1472, -0.2376, -0.0110, -0.1538, 0.4067, -0.1162, -0.1611, -0.3036, 0.1920, 0.0524, -0.1154, 0.2119, 0.6998, -0.0372, -0.1147, 0.0808, -0.0208, 0.0743, -0.6911, 0.5789, -0.1364, -0.2762, -0.2336, -0.3745, 0.3618, -0.3815, -0.0863, -0.1517, 0.2634, 0.1668, -0.1089, 0.1157, 0.5418, -0.1517, -0.5003, 0.2228, 0.0187, -0.1660, 0.3784, 0.0851, -0.4641, 0.4642, -0.2010, 0.1137, -0.4869, 0.0436, 0.4685, 0.6349, -0.2303, 0.0658, 0.2415, -0.3125, -0.8469, 0.0241, -0.1227, 0.0472, 0.1470, 0.8610, -0.8610]] [[ 0.5141, -0.1032, -0.5393, 0.2102, -0.2530, 0.2205, 0.1902, 0.4044, -0.1831, -1.0262, -0.0026, 0.0394, -0.2488, 0.0921, -0.0245, -0.0255, -0.2329, 0.2788, 0.3674, -0.0941, 0.4909, 0.6036, -0.1140, -0.1987, -0.3554, -0.1912, 0.4395, 0.1757, -0.3690, 0.0589, 0.0112, 0.0299, 0.5158, -0.0630, -0.4405, 0.1830, 0.0858, 0.1610, -0.0855, 0.4073, 0.1304, -0.3468, 0.2418, 0.1515, -0.2435, -0.0112, -0.1575, 0.4254, -0.1189, -0.1655, -0.3105, 0.1979, 0.0535, -0.1187, 0.2176, 0.7279, -0.0388, -0.1179, 0.0831, -0.0218, 0.0731, -0.6963, 0.5787, -0.1358, -0.2793, -0.2339, -0.3769, 0.3695, -0.3853, -0.0895, -0.1574, 0.2653, 0.1662, -0.1126, 0.1169, 0.5556, -0.1545, -0.5034, 0.2233, 0.0153, -0.1648, 0.3837, 0.0853, -0.4647, 0.4673, -0.2006, 0.1161, -0.4946, 0.0473, 0.4716, 0.6405, -0.2322, 0.0665, 0.2452, -0.3137, -0.8607, 0.0270, -0.1197, 0.0466, 0.1504, 0.8814, -0.8814]] [[ 0.5129, -0.1032, -0.5444, 0.2122, -0.2526, 0.2147, 0.1897, 0.4036, -0.1761, -1.0292, -0.0028, 0.0396, -0.2511, 0.0931, -0.0218, -0.0221, -0.2335, 0.2828, 0.3696, -0.0964, 0.4943, 0.6047, -0.1134, -0.1974, -0.3549, -0.1912, 0.4412, 0.1765, -0.3669, 0.0592, 0.0104, 0.0282, 0.5166, -0.0632, -0.4421, 0.1840, 0.0852, 0.1607, -0.0864, 0.4081, 0.1329, -0.3543, 0.2470, 0.1554, -0.2489, -0.0115, -0.1609, 0.4420, -0.1215, -0.1696, -0.3169, 0.2034, 0.0545, -0.1218, 0.2227, 0.7540, -0.0404, -0.1208, 0.0853, -0.0228, 0.0719, -0.7016, 0.5784, -0.1353, -0.2834, -0.2343, -0.3793, 0.3771, -0.3889, -0.0925, -0.1629, 0.2667, 0.1650, -0.1161, 0.1177, 0.5688, -0.1572, -0.5066, 0.2238, 0.0120, -0.1636, 0.3890, 0.0857, -0.4653, 0.4714, -0.2003, 0.1185, -0.5022, 0.0509, 0.4746, 0.6460, -0.2337, 0.0677, 0.2488, -0.3145, -0.8739, 0.0297, -0.1165, 0.0462, 0.1537, 0.9000, -0.9000]] [[ 0.5119, -0.1031, -0.5497, 0.2129, -0.2523, 0.2093, 0.1892, 0.4030, -0.1698, -1.0329, -0.0030, 0.0397, -0.2535, 0.0936, -0.0205, -0.0204, -0.2344, 0.2862, 0.3715, -0.0986, 0.4975, 0.6058, -0.1126, -0.1953, -0.3544, -0.1910, 0.4428, 0.1773, -0.3646, 0.0602, 0.0108, 0.0285, 0.5173, -0.0633, -0.4438, 0.1846, 0.0846, 0.1605, -0.0872, 0.4088, 0.1351, -0.3613, 0.2519, 0.1592, -0.2536, -0.0117, -0.1640, 0.4573, -0.1241, -0.1736, -0.3229, 0.2086, 0.0553, -0.1247, 0.2275, 0.7788, -0.0420, -0.1235, 0.0874, -0.0238, 0.0710, -0.7067, 0.5783, -0.1346, -0.2885, -0.2346, -0.3816, 0.3845, -0.3922, -0.0953, -0.1680, 0.2678, 0.1634, -0.1194, 0.1184, 0.5816, -0.1597, -0.5096, 0.2243, 0.0091, -0.1627, 0.3940, 0.0858, -0.4659, 0.4766, -0.2000, 0.1208, -0.5096, 0.0543, 0.4774, 0.6511, -0.2348, 0.0693, 0.2521, -0.3151, -0.8866, 0.0321, -0.1134, 0.0457, 0.1567, 0.9173, -0.9173]] [[ 0.5111, -0.1032, -0.5546, 0.2132, -0.2521, 0.2042, 0.1886, 0.4023, -0.1636, -1.0367, -0.0032, 0.0399, -0.2557, 0.0940, -0.0197, -0.0196, -0.2352, 0.2893, 0.3732, -0.1004, 0.5005, 0.6071, -0.1120, -0.1929, -0.3540, -0.1908, 0.4442, 0.1783, -0.3626, 0.0611, 0.0114, 0.0290, 0.5180, -0.0633, -0.4453, 0.1851, 0.0841, 0.1603, -0.0880, 0.4096, 0.1373, -0.3679, 0.2565, 0.1627, -0.2580, -0.0120, -0.1670, 0.4717, -0.1265, -0.1773, -0.3287, 0.2136, 0.0561, -0.1276, 0.2319, 0.8024, -0.0435, -0.1261, 0.0894, -0.0247, 0.0703, -0.7113, 0.5783, -0.1341, -0.2937, -0.2349, -0.3838, 0.3918, -0.3954, -0.0978, -0.1730, 0.2688, 0.1617, -0.1225, 0.1191, 0.5940, -0.1618, -0.5123, 0.2248, 0.0063, -0.1620, 0.3987, 0.0857, -0.4665, 0.4817, -0.1997, 0.1230, -0.5169, 0.0574, 0.4799, 0.6561, -0.2357, 0.0709, 0.2552, -0.3159, -0.8990, 0.0342, -0.1107, 0.0452, 0.1594, 0.9335, -0.9335]] [[ 0.5103, -0.1034, -0.5591, 0.2133, -0.2522, 0.1992, 0.1880, 0.4016, -0.1574, -1.0403, -0.0033, 0.0401, -0.2576, 0.0945, -0.0192, -0.0193, -0.2359, 0.2923, 0.3747, -0.1018, 0.5033, 0.6085, -0.1114, -0.1905, -0.3536, -0.1906, 0.4456, 0.1794, -0.3608, 0.0618, 0.0121, 0.0291, 0.5186, -0.0632, -0.4467, 0.1854, 0.0835, 0.1600, -0.0887, 0.4104, 0.1393, -0.3742, 0.2608, 0.1660, -0.2623, -0.0122, -0.1697, 0.4856, -0.1288, -0.1808, -0.3342, 0.2184, 0.0569, -0.1303, 0.2360, 0.8250, -0.0449, -0.1285, 0.0912, -0.0256, 0.0698, -0.7156, 0.5785, -0.1336, -0.2987, -0.2352, -0.3857, 0.3988, -0.3983, -0.1001, -0.1780, 0.2698, 0.1601, -0.1256, 0.1198, 0.6060, -0.1637, -0.5149, 0.2252, 0.0037, -0.1615, 0.4030, 0.0856, -0.4669, 0.4867, -0.1994, 0.1249, -0.5239, 0.0603, 0.4822, 0.6611, -0.2367, 0.0725, 0.2582, -0.3166, -0.9111, 0.0362, -0.1082, 0.0448, 0.1621, 0.9488, -0.9488]] [[ 0.5095, -0.1036, -0.5633, 0.2133, -0.2521, 0.1946, 0.1873, 0.4010, -0.1514, -1.0439, -0.0034, 0.0403, -0.2595, 0.0950, -0.0186, -0.0192, -0.2369, 0.2950, 0.3761, -0.1030, 0.5061, 0.6101, -0.1107, -0.1881, -0.3532, -0.1904, 0.4468, 0.1807, -0.3591, 0.0624, 0.0129, 0.0292, 0.5192, -0.0630, -0.4481, 0.1857, 0.0830, 0.1597, -0.0893, 0.4111, 0.1411, -0.3801, 0.2649, 0.1692, -0.2663, -0.0124, -0.1723, 0.4987, -0.1310, -0.1842, -0.3394, 0.2230, 0.0576, -0.1328, 0.2399, 0.8467, -0.0463, -0.1308, 0.0930, -0.0265, 0.0695, -0.7197, 0.5787, -0.1332, -0.3036, -0.2355, -0.3876, 0.4057, -0.4011, -0.1022, -0.1828, 0.2706, 0.1586, -0.1285, 0.1206, 0.6177, -0.1655, -0.5172, 0.2255, 0.0012, -0.1612, 0.4071, 0.0853, -0.4673, 0.4916, -0.1991, 0.1268, -0.5308, 0.0631, 0.4844, 0.6660, -0.2376, 0.0741, 0.2612, -0.3174, -0.9228, 0.0379, -0.1058, 0.0444, 0.1646, 0.9632, -0.9632]] [[ 0.5088, -0.1039, -0.5674, 0.2131, -0.2520, 0.1903, 0.1867, 0.4003, -0.1459, -1.0475, -0.0035, 0.0405, -0.2612, 0.0954, -0.0181, -0.0190, -0.2380, 0.2973, 0.3774, -0.1043, 0.5089, 0.6116, -0.1100, -0.1856, -0.3528, -0.1902, 0.4481, 0.1819, -0.3576, 0.0627, 0.0137, 0.0294, 0.5197, -0.0628, -0.4494, 0.1860, 0.0825, 0.1594, -0.0900, 0.4118, 0.1429, -0.3858, 0.2688, 0.1722, -0.2701, -0.0126, -0.1748, 0.5114, -0.1329, -0.1875, -0.3444, 0.2273, 0.0582, -0.1353, 0.2435, 0.8675, -0.0476, -0.1330, 0.0946, -0.0274, 0.0691, -0.7236, 0.5790, -0.1329, -0.3084, -0.2357, -0.3894, 0.4123, -0.4037, -0.1043, -0.1876, 0.2715, 0.1570, -0.1314, 0.1214, 0.6290, -0.1672, -0.5194, 0.2259, -0.0012, -0.1608, 0.4110, 0.0851, -0.4677, 0.4964, -0.1988, 0.1286, -0.5374, 0.0658, 0.4864, 0.6708, -0.2384, 0.0756, 0.2641, -0.3181, -0.9341, 0.0396, -0.1036, 0.0441, 0.1670, 0.9768, -0.9768]] [[ 0.5081, -0.1043, -0.5712, 0.2133, -0.2518, 0.1863, 0.1860, 0.3996, -0.1402, -1.0509, -0.0036, 0.0406, -0.2629, 0.0957, -0.0176, -0.0189, -0.2392, 0.2996, 0.3785, -0.1056, 0.5117, 0.6132, -0.1092, -0.1832, -0.3525, -0.1900, 0.4493, 0.1833, -0.3562, 0.0628, 0.0145, 0.0296, 0.5203, -0.0625, -0.4506, 0.1861, 0.0821, 0.1591, -0.0906, 0.4126, 0.1445, -0.3910, 0.2724, 0.1750, -0.2738, -0.0128, -0.1771, 0.5235, -0.1348, -0.1906, -0.3492, 0.2315, 0.0587, -0.1377, 0.2469, 0.8874, -0.0489, -0.1351, 0.0962, -0.0283, 0.0688, -0.7273, 0.5793, -0.1326, -0.3131, -0.2360, -0.3911, 0.4187, -0.4063, -0.1063, -0.1923, 0.2723, 0.1554, -0.1342, 0.1221, 0.6400, -0.1688, -0.5215, 0.2262, -0.0035, -0.1605, 0.4147, 0.0847, -0.4680, 0.5012, -0.1986, 0.1303, -0.5438, 0.0683, 0.4884, 0.6755, -0.2392, 0.0772, 0.2669, -0.3188, -0.9450, 0.0413, -0.1015, 0.0437, 0.1693, 0.9896, -0.9896]] [[ 0.5075, -0.1047, -0.5748, 0.2136, -0.2517, 0.1824, 0.1854, 0.3990, -0.1348, -1.0543, -0.0036, 0.0408, -0.2645, 0.0960, -0.0171, -0.0188, -0.2403, 0.3017, 0.3796, -0.1069, 0.5144, 0.6148, -0.1083, -0.1809, -0.3521, -0.1898, 0.4505, 0.1846, -0.3548, 0.0630, 0.0154, 0.0298, 0.5208, -0.0622, -0.4518, 0.1863, 0.0816, 0.1588, -0.0912, 0.4133, 0.1461, -0.3960, 0.2759, 0.1777, -0.2772, -0.0129, -0.1794, 0.5351, -0.1366, -0.1936, -0.3538, 0.2356, 0.0592, -0.1400, 0.2501, 0.9065, -0.0501, -0.1371, 0.0976, -0.0291, 0.0686, -0.7309, 0.5797, -0.1323, -0.3177, -0.2362, -0.3927, 0.4250, -0.4087, -0.1082, -0.1969, 0.2731, 0.1539, -0.1370, 0.1228, 0.6506, -0.1704, -0.5235, 0.2265, -0.0057, -0.1603, 0.4182, 0.0844, -0.4682, 0.5057, -0.1983, 0.1319, -0.5501, 0.0708, 0.4903, 0.6801, -0.2400, 0.0787, 0.2696, -0.3195, -0.9557, 0.0428, -0.0995, 0.0434, 0.1715, 1.0017, -1.0017]] [[ 0.5069, -0.1051, -0.5782, 0.2140, -0.2515, 0.1787, 0.1847, 0.3984, -0.1298, -1.0575, -0.0037, 0.0410, -0.2661, 0.0961, -0.0166, -0.0187, -0.2414, 0.3038, 0.3807, -0.1080, 0.5172, 0.6164, -0.1074, -0.1787, -0.3519, -0.1896, 0.4517, 0.1860, -0.3535, 0.0633, 0.0163, 0.0300, 0.5214, -0.0619, -0.4530, 0.1864, 0.0812, 0.1585, -0.0917, 0.4140, 0.1476, -0.4007, 0.2793, 0.1802, -0.2806, -0.0131, -0.1815, 0.5463, -0.1383, -0.1965, -0.3582, 0.2394, 0.0597, -0.1422, 0.2531, 0.9250, -0.0513, -0.1390, 0.0990, -0.0299, 0.0684, -0.7343, 0.5801, -0.1320, -0.3222, -0.2365, -0.3942, 0.4311, -0.4110, -0.1100, -0.2014, 0.2738, 0.1524, -0.1396, 0.1234, 0.6610, -0.1719, -0.5255, 0.2268, -0.0078, -0.1601, 0.4216, 0.0840, -0.4685, 0.5102, -0.1981, 0.1334, -0.5562, 0.0731, 0.4921, 0.6846, -0.2407, 0.0802, 0.2723, -0.3202, -0.9660, 0.0443, -0.0976, 0.0431, 0.1736, 1.0133, -1.0133]] [[ 0.5063, -0.1055, -0.5816, 0.2142, -0.2511, 0.1754, 0.1840, 0.3978, -0.1251, -1.0607, -0.0037, 0.0411, -0.2676, 0.0963, -0.0161, -0.0185, -0.2423, 0.3059, 0.3818, -0.1090, 0.5199, 0.6179, -0.1063, -0.1766, -0.3516, -0.1894, 0.4528, 0.1873, -0.3522, 0.0635, 0.0171, 0.0302, 0.5219, -0.0615, -0.4542, 0.1864, 0.0808, 0.1582, -0.0923, 0.4147, 0.1490, -0.4052, 0.2825, 0.1827, -0.2837, -0.0133, -0.1836, 0.5571, -0.1399, -0.1993, -0.3624, 0.2430, 0.0601, -0.1444, 0.2560, 0.9427, -0.0525, -0.1409, 0.1004, -0.0307, 0.0681, -0.7375, 0.5805, -0.1318, -0.3265, -0.2367, -0.3957, 0.4370, -0.4133, -0.1117, -0.2058, 0.2745, 0.1509, -0.1423, 0.1241, 0.6710, -0.1733, -0.5273, 0.2271, -0.0098, -0.1598, 0.4249, 0.0836, -0.4687, 0.5145, -0.1979, 0.1349, -0.5621, 0.0753, 0.4939, 0.6889, -0.2415, 0.0817, 0.2749, -0.3209, -0.9760, 0.0458, -0.0958, 0.0429, 0.1755, 1.0242, -1.0242]] [[ 0.5057, -0.1060, -0.5848, 0.2145, -0.2507, 0.1726, 0.1834, 0.3972, -0.1206, -1.0637, -0.0038, 0.0413, -0.2691, 0.0964, -0.0156, -0.0184, -0.2432, 0.3079, 0.3828, -0.1099, 0.5226, 0.6194, -0.1052, -0.1745, -0.3513, -0.1892, 0.4540, 0.1887, -0.3509, 0.0639, 0.0179, 0.0304, 0.5224, -0.0612, -0.4553, 0.1864, 0.0803, 0.1579, -0.0928, 0.4153, 0.1503, -0.4095, 0.2855, 0.1850, -0.2868, -0.0134, -0.1855, 0.5674, -0.1415, -0.2019, -0.3665, 0.2466, 0.0605, -0.1464, 0.2588, 0.9598, -0.0536, -0.1426, 0.1017, -0.0315, 0.0679, -0.7407, 0.5809, -0.1316, -0.3307, -0.2369, -0.3972, 0.4427, -0.4154, -0.1134, -0.2100, 0.2753, 0.1495, -0.1448, 0.1247, 0.6807, -0.1747, -0.5290, 0.2273, -0.0117, -0.1596, 0.4280, 0.0832, -0.4689, 0.5187, -0.1977, 0.1364, -0.5678, 0.0775, 0.4955, 0.6932, -0.2422, 0.0832, 0.2775, -0.3215, -0.9858, 0.0472, -0.0940, 0.0426, 0.1775, 1.0347, -1.0347]] [[ 0.5051, -0.1064, -0.5878, 0.2147, -0.2506, 0.1694, 0.1828, 0.3966, -0.1159, -1.0667, -0.0039, 0.0414, -0.2705, 0.0965, -0.0151, -0.0183, -0.2440, 0.3099, 0.3838, -0.1108, 0.5253, 0.6209, -0.1041, -0.1726, -0.3511, -0.1890, 0.4551, 0.1900, -0.3496, 0.0644, 0.0187, 0.0306, 0.5229, -0.0608, -0.4564, 0.1865, 0.0799, 0.1576, -0.0933, 0.4160, 0.1516, -0.4136, 0.2882, 0.1872, -0.2897, -0.0136, -0.1874, 0.5774, -0.1431, -0.2045, -0.3704, 0.2499, 0.0608, -0.1484, 0.2614, 0.9763, -0.0547, -0.1443, 0.1029, -0.0322, 0.0677, -0.7437, 0.5813, -0.1314, -0.3347, -0.2371, -0.3985, 0.4483, -0.4175, -0.1150, -0.2141, 0.2760, 0.1480, -0.1473, 0.1253, 0.6902, -0.1761, -0.5307, 0.2276, -0.0136, -0.1594, 0.4310, 0.0827, -0.4691, 0.5227, -0.1974, 0.1377, -0.5734, 0.0795, 0.4972, 0.6973, -0.2429, 0.0846, 0.2800, -0.3221, -0.9952, 0.0485, -0.0923, 0.0424, 0.1793, 1.0446, -1.0446]] ========================================================================================================================================================================================================================================================== LayerName (LayerType) nIn,nOut TotalParams ParamsShape ========================================================================================================================================================================================================================================================== layer0 (DenseLayer) 2,20 60 W:{2,20}, b:{1,20} layer1 (OutputLayer) 20,2 42 W:{20,2}, b:{1,2} ---------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------------- Total Parameters: 102 Trainable Parameters: 102 Frozen Parameters: 0 ========================================================================================================================================================================================================================================================== {0_W=[[ 0.5051, -0.5878, -0.2506, 0.1828, -0.1159, -0.0039, -0.2705, -0.0151, -0.2440, 0.3838, 0.5253, -0.1041, -0.3511, 0.4551, -0.3496, 0.0187, 0.5229, -0.4564, 0.0799, -0.0933], [ -0.1064, 0.2147, 0.1694, 0.3966, -1.0667, 0.0414, 0.0965, -0.0183, 0.3099, -0.1108, 0.6209, -0.1726, -0.1890, 0.1900, 0.0644, 0.0306, -0.0608, 0.1865, 0.1576, 0.4160]], 0_b=[[ 0.1516, -0.4136, 0.2882, 0.1872, -0.2897, -0.0136, -0.1874, 0.5774, -0.1431, -0.2045, -0.3704, 0.2499, 0.0608, -0.1484, 0.2614, 0.9763, -0.0547, -0.1443, 0.1029, -0.0322]], 1_W=[[ 0.0677, -0.1594], [ -0.7437, 0.4310], [ 0.5813, 0.0827], [ -0.1314, -0.4691], [ -0.3347, 0.5227], [ -0.2371, -0.1974], [ -0.3985, 0.1377], [ 0.4483, -0.5734], [ -0.4175, 0.0795], [ -0.1150, 0.4972], [ -0.2141, 0.6973], [ 0.2760, -0.2429], [ 0.1480, 0.0846], [ -0.1473, 0.2800], [ 0.1253, -0.3221], [ 0.6902, -0.9952], [ -0.1761, 0.0485], [ -0.5307, -0.0923], [ 0.2276, 0.0424], [ -0.0136, 0.1793]], 1_b=[[ 1.0446, -1.0446]]} Evaluate model.... ========================Evaluation Metrics======================== # of classes: 2 Accuracy: 1.0000 Precision: 1.0000 Recall: 1.0000 F1 Score: 1.0000 Precision, recall & F1: reported for positive class (class 1 - "1") only =========================Confusion Matrix========================= 0 1 ------- 48 0 | 0 = 0 0 52 | 1 = 1 Confusion matrix format: Actual (rowClass) predicted as (columnClass) N times ================================================================== ****************Example finished******************** |

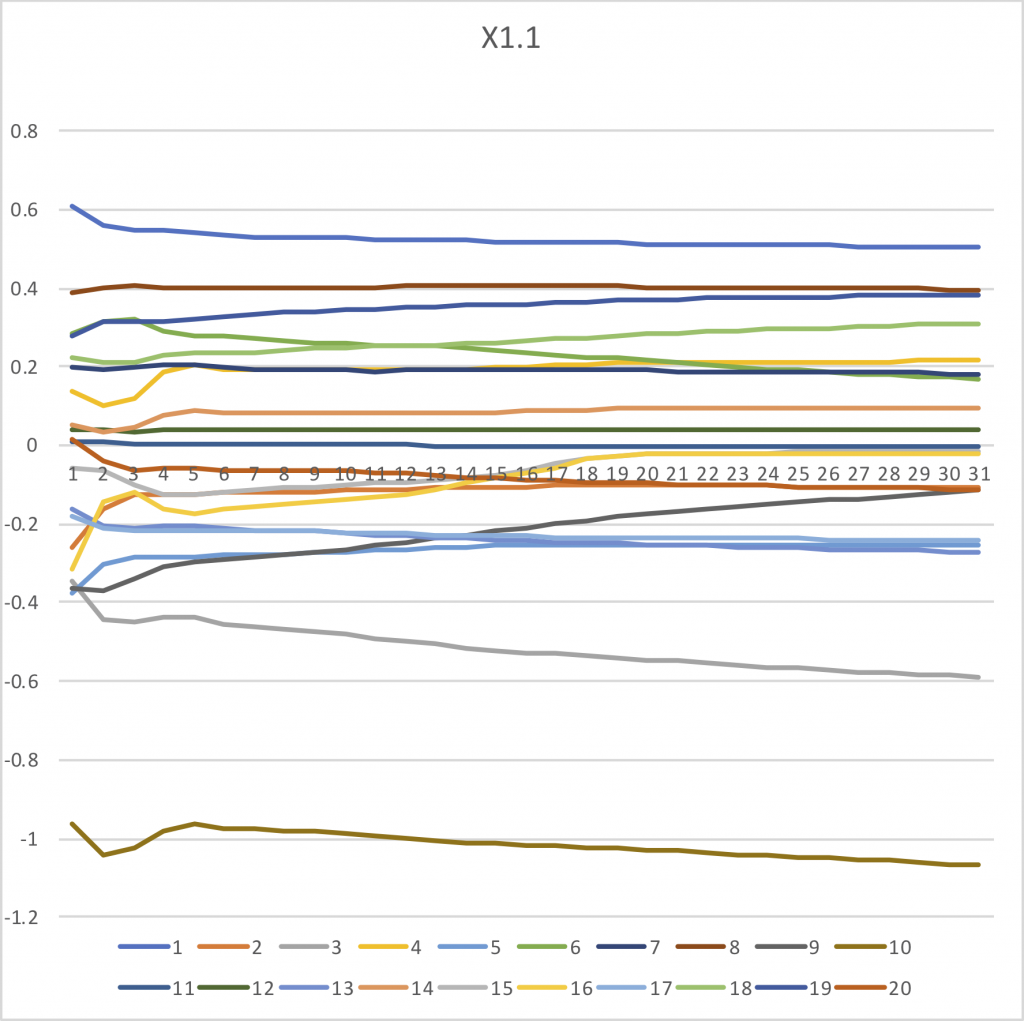

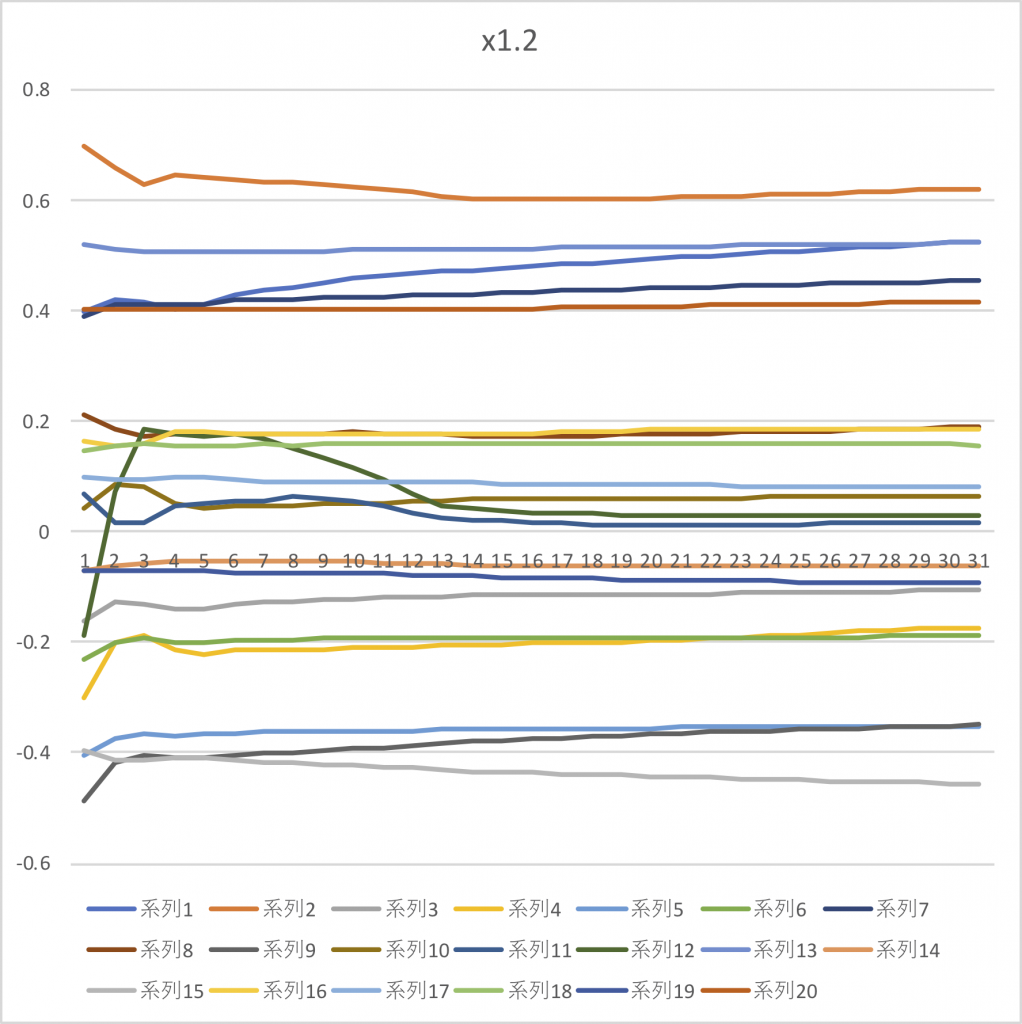

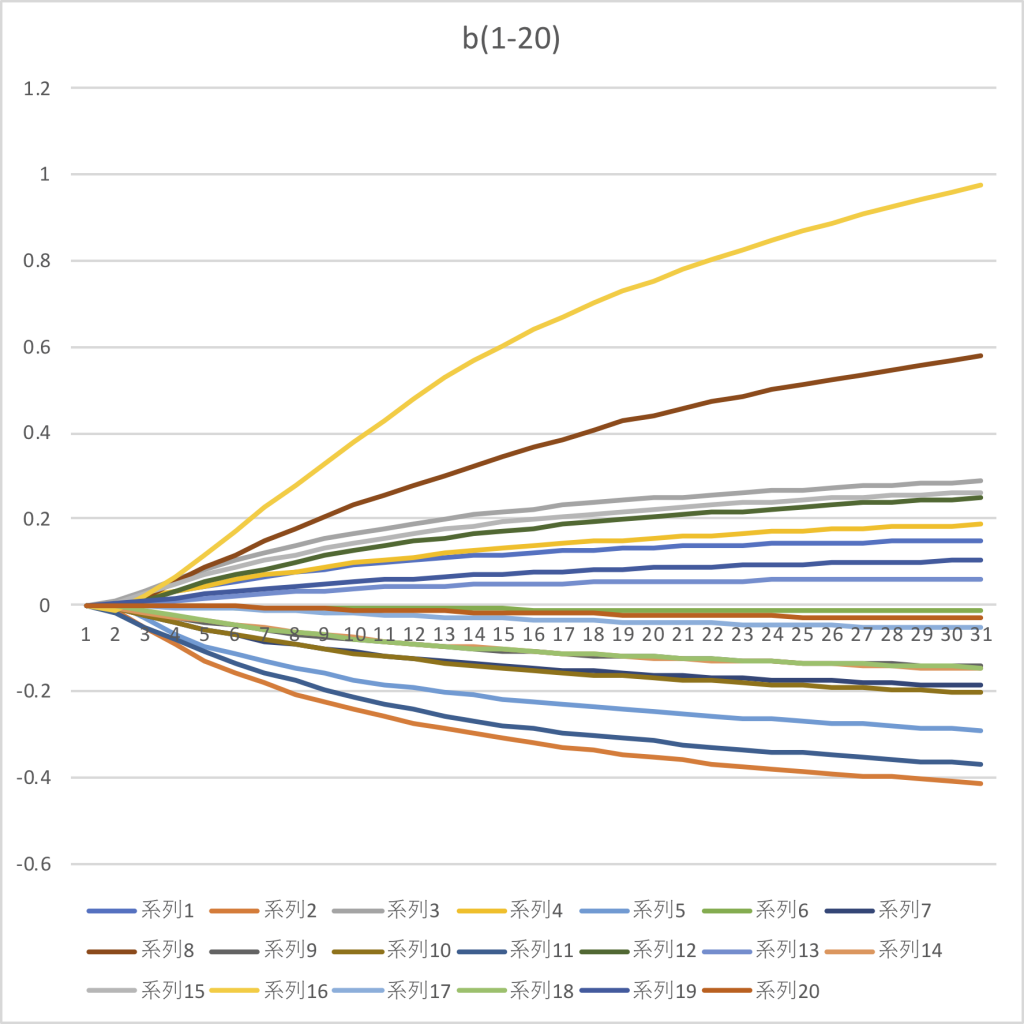

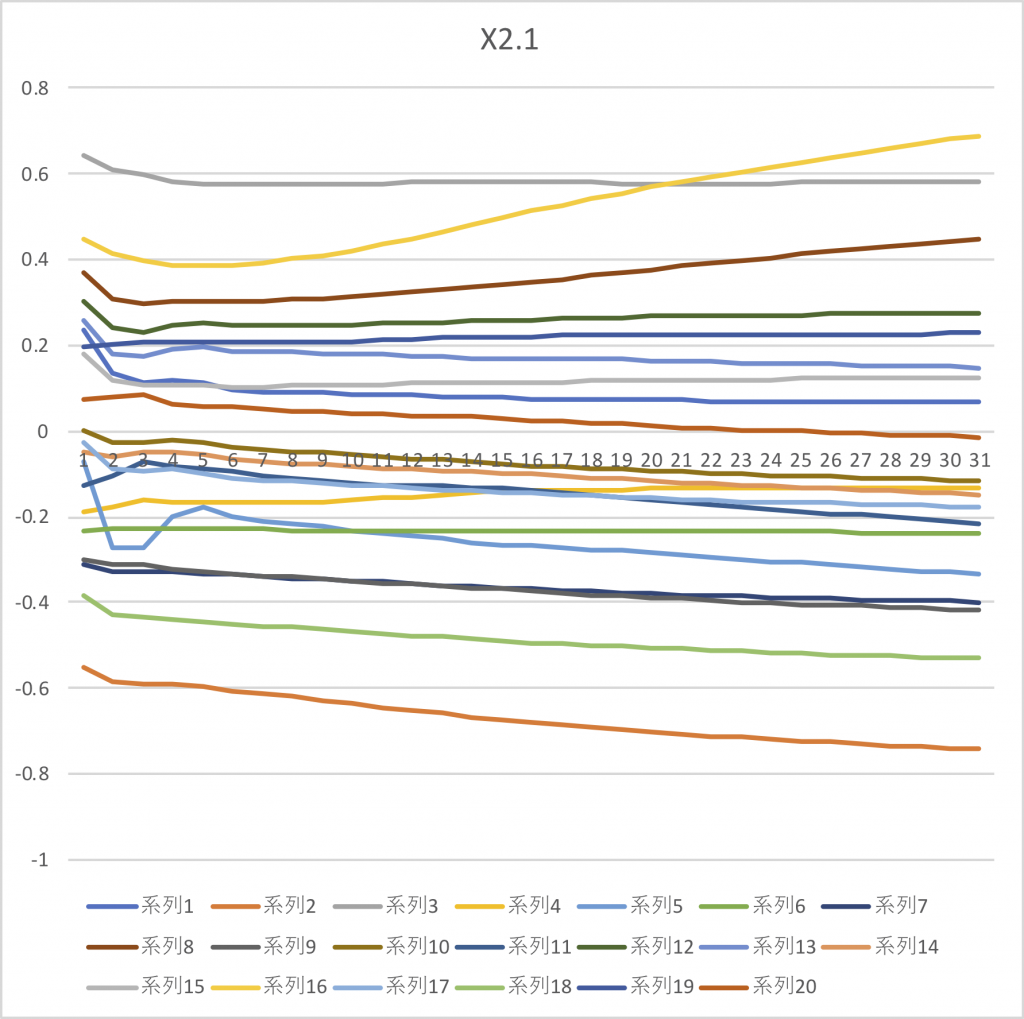

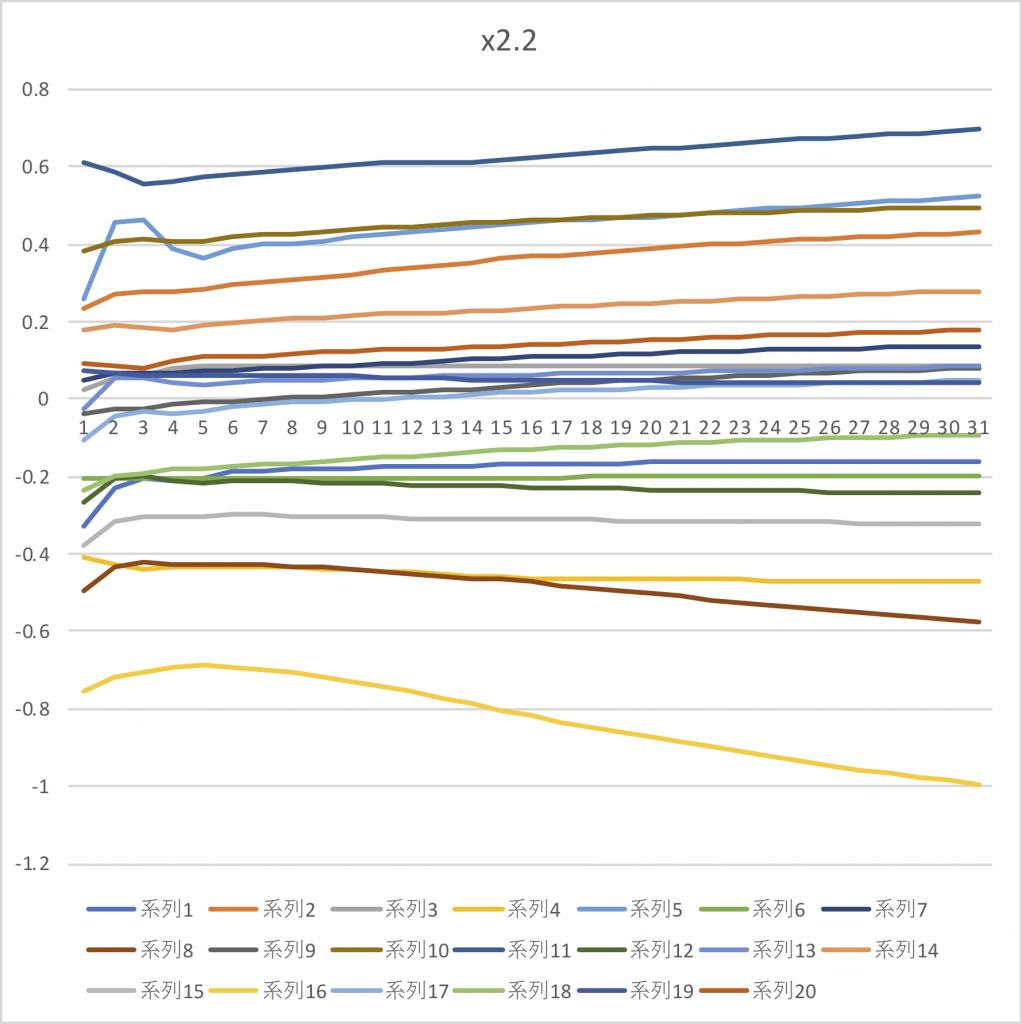

パラメータ初期値、中間値、最終値をエクセルに取り込んで、パラメータの変化をグラフにしてみると以下の通り:

このようにザビエルの初期値で選ばれた重み係数は、初期値からあまり変化していないが、バイアス値はゼロから始まり大きく変化していることがわかる。重みの初期値は、一般的にはガウス分布からランダムに生成したものを初期値とし、バイアス初期値はゼロとするのが通常のようだ。

重みの初期値はその後の学習に大きく影響する。

以下のようにconvolution層でもいろいろな方法がある。

http://arakan-pgm-ai.hatenablog.com/entry/2017/09/02/003000

ーーーーーーーーーーーーーーーーーーーーーーーー

Uniform:-1.0?1.0の一様乱数で初期化

UniformAffineGlorot:一様乱数にXavier Glorot提案の 係数をかけて初期化

Normal:平均0.0、分散1.0であるガウス乱数で初期化

NormalAffineHeForward:ガウス乱数にKaiming He提案の係数をかけて初期化(Forward Case)

NormalAffineHeBackward:ガウス乱数にKaiming He提案の係数をかけて初期化(Backward Case)

NormalAffineGlorot:ガウス乱数にXavier Glorot提案の 係数をかけて初期化(デフォルト)

Constant:全ての要素を一定値(1.0)で初期化

ーーーーーーーーーーーーーーーーーーーーーーーー

上記のうち、説明に「Xavier Glorot提案」と書かれている種類が「Xavierの初期値」と呼ばれるもの。 「ザビエXavierの初期値」は層のノードの数によって、作用させる係数を変化させる。たとえば、前層から渡されるノード数がn個であるときには、標準偏差√nで割る。